mult1plexer

-

Количество публикаций

49 -

Зарегистрирован

-

Посещение

Сообщения, опубликованные пользователем mult1plexer

-

-

-

Ищете ответ на вопрос в направлении семантической сегментации. Эта задача уже решена

http://mi.eng.cam.ac.uk/projects/segnet/#demo

https://github.com/alexgkendall/caffe-segnet

-

16 часов назад, LexaP сказал:Только я бы посоветовал применить ИК, делать анализ закрытия глаза именно по зрачку, а не в момент смыкания век.

например как на одном из кадров. Глаз открыт, но детекция закрытости..

Эти данные нам прислали для обработки, есть видео где ик включено, но не хватает освещения, часть лица темная.

Зрачок не совсем виден, во многих ситуация, например при критических углах.

-

-

4 часа назад, LexaP сказал:Показал, то, что было.

Остальное нет смысла показывать, так как там запись с устройства которое поставляется заказчику.

Да и толку нет в этом видео., видео можно смонтировать или еще как то....

нет я просто хотел сравнить со своим без оптимизаций и тд

-

9 часов назад, LexaP сказал:На расберри (старое), но тут оценить сложно скорость.

Отображение идет через веб браузер, обновление станицы раз в сек.

самого интересного не увидел детекция глаз открыты\закрыты и ландмарк оптимизированный или он только для скорости?

-

В 16.03.2019 at 23:33, LexaP сказал:Собственная разработка, в свободном доступе нет, так как коммерческий продукт.

Моделька для рисования точек взята из DLIB с "оптимизацией слоев".

а ктати у вас нет демо ролика работы вашего приложения на плате?

-

2 часа назад, LexaP сказал:Собственная разработка, в свободном доступе нет, так как коммерческий продукт.

Моделька для рисования точек взята из DLIB с "оптимизацией слоев".

Попробуйте этот вариант

https://github.com/freesouls/face-alignment-at-3000fps

Но мне не понравилось, так как нужно обучать всегда (как я помню)

Моделька для рисования точек взята из DLIB с "оптимизацией слоев".

А что такое "оптимизацией слоев" и что это дает?

-

20 минут назад, LexaP сказал:"Например этот алгоритм c адаптацией под ARM выдает 100-150 fps на i5 процессоре"

Это ваш алгоритм или он есть в свободном доступе?

-

2 часа назад, LexaP сказал:Плата достаточно мощная.

У меня на расберри ведется анализ засыпания водителя. В среднем 11 кадров в сек получаю.

Основная структура проекта (софтерная)

- Поиск головы сомописной сеткой на основе YOLO и CAFFE

- Далее находим глаза, через svm + алгоритмы бинаризации и прочие. На одной сетке точность будет ниже.

Но у меня используется еще ИК подсветка, с ней искать глаза проще.

1. У меня по тз минимум 25 fps

2. На каком фраймворке YOLO используете, через opencv dnn можно ее загрузить?

3. svm есть для глаз из "коробки"?

4. ик тоже есть, но зрачок это не позволяет найти аналитически, слижком много разных ситуаций, да и детализация не позволяет блики находить или окружность зрачка

-

5 часов назад, Nuzhny сказал:1. На каком расстоянии и какой размер глаз в пикселях будет на кадре? Глаз - это точка или протяжённый объект?

2. Можно детектировать landmark'и какой-нибудь нейросеткой ( например отсюда ), а потом трекать их, сглаживая погрешности детектора.

1. Расстояние от 90 см до 2 метров. Вообще задача стоит по определению закрыт или открыт глаз + наличие очков с диоптриями от -7 до + 7

2.Ландмарки из коробки имеют очень ограниченные углы обнаружения, срывы наблюдаются уже при отклонении выше 20° и локализовать глаз нет возможности. Трекеры вешал, но они не стабильно работают при повороте головы идет срыв/ложное детектирование

все сетки какие я тестировал тяжелые, необходима работа на отладочной плате с Rockchip rk3399 (нет поддержки cuda, openvino)

-

5 часов назад, Pechkin80 сказал:Да.

а смысл, это черный ящик, зачем туда лезть. Для этого собственно и создаются фраймворки технического зрения, чтобы вы не занимались их изучением и реализацией.

-

Здравствуйте. Никто не знает, чем можно детектировать глаза, помимо cascade haar (opencv) и landmark's моделей? Чем то более стабильным и точным

-

"изучение кода DLib" исходный код в смысле?

-

В 05.02.2019 at 00:32, ppop21285 сказал:Для аппаратного декодирования h.264/h.265/mpeg4/MJPEG можно взять библиотеки из проекта ffmpeg. Там есть реализаций кодеков с использованием SDK от NVIDIA, AMD и INTEL, также есть варианты для мобильных устройств. В ffmpeg есть свой модуль для работы с камерами. OpenCV версий 3 и 4 можно собрать с поддержкой ffmpeg для декодирования.

Применяя аппаратный декодер и OpenCV модули с поддержкой NVIDIA Cuda и/или OpenCL, есть возможность построить алгоритмы без копирования декодированного потока в хост память. DirectX и OpenGL поверхности в памяти GPU могут являться источником для OpenCl/Cuda матриц в OpenCV не покидая GPU.

В 05.02.2019 at 12:21, Nuzhny сказал:С ip камерами как раз всё проще. Их можно пачкой на CUDA декодировать, а потом обрабатывать изображения, не выгружая декодированные кадры из видеопамяти. Можно отдавать их, например в TensorFlow.

из gpu есть Mali T860

-

20 часов назад, Pechkin80 сказал:А что за камера ? Камера работает по протоколу обычно и не привязана к кодеку. Если только совсем какойто ширпотреб.

китайские нонейм модули без опознавательных знаков

13 часа назад, Nuzhny сказал:Веб-камеры используются не по протоколу, а через драйвер. Может оказаться, для неё есть DirectShow драйвер и всё. Но тут ещё вопрос, используется ли DirectShow или сейчас всё реализовано через MSMF. Всё - это dshow и vfw.

Думаю, что плайеры работают через DXVA, которое позволяет сразу декодировать и отображать видео. Сходу даже не уверен, можно ли его использовать в OpenCV.

так в этом и суть, что MPC-HC от k-lite захватывает нормально не через DirectShow. Значит как минимум это можно как то поменять. В opencv проблема даже в FHD сделать захват, FPS падает до 7-10. А по дефолту открывает в 640х480

-

15 часов назад, Nuzhny сказал:Можно у Capture посмотреть свойство CAP_PROP_BACKEND.

что это даст? камера работает только с DSHOW в opencv, в VLC тоже самое только через DSHOW

-

8 часов назад, Nuzhny сказал:Попробуй принудительно изменить backend у capture: CAP_FFMPEG, CAP_DSHOW или CAP_VFW. Они выбираются по очереди, какой первый подойдёт. Возможно, что у тебя первый в списке как раз не аппаратный.

это я первым делом сделал. как я понял у меня через directshow идет, с gstreamer не удалось запустить завершается 0xc000007b ошибкой

8 часов назад, Pechkin80 сказал:Для линукса по идеи нужен GStreamer. Интересная статья по теме:

https://blog.zhaw.ch/high-performance/2017/10/24/boost-your-gstreamer-pipeline-with-the-gpu-plugin/

я пока под windows запускаю.

-

3 часа назад, fotomer сказал:А что вы собираетесь делать с полученной cv::Мат картинкой? Многие алгоритмы вообще онлайн не работают на обычном железе.

что значит не работают онлайн? не понял этот тезис

-

Здравствуйте. Столкнулся с проблемой получения кадра с веб камеры и видео. Как оказалось opencv использует программное декодирование видео потока. В результате чего не могу получить 60fps и убрать нагрузку с процессора. Через проигрыватель, который идет с K-Lite Codec Pack все воспроизводится так как надо. Кто нибудь решал такую проблему или может есть другой способ получать кадры с видео?

-

1

1

-

-

-

4 часа назад, fotomer сказал:А калибровку камеры делал? Если да, то какой reprojection_error получился? У меня для камеры с фикс-объективом меньше 0.3 не получилось, для обычной мыльницы 0.8, снимков делал ок.40 штук.

снимки уже ректифицированные использовал, фокус, база и т.д эмпирически

-

5 часов назад, fotomer сказал:Как реализовал нахождение фундаментальной матрицы? И последующее ее разложение для поиска R и t ?

findEssentialMat + recoverPose (Opencv), сейчас реализовано частично своими методами

4 часа назад, Nuzhny сказал:Я ICP использовал когда-то из PCL. Библиотека сейчас выглядит не очень живой, но работало хорошо.

А порядок действий я так понимаю такой: регистрируем первое облако, потом второе, далее ищем общие пары, находим расхождение, с помощью матриц трансляции и поворота, минимизируем расхождение?

-

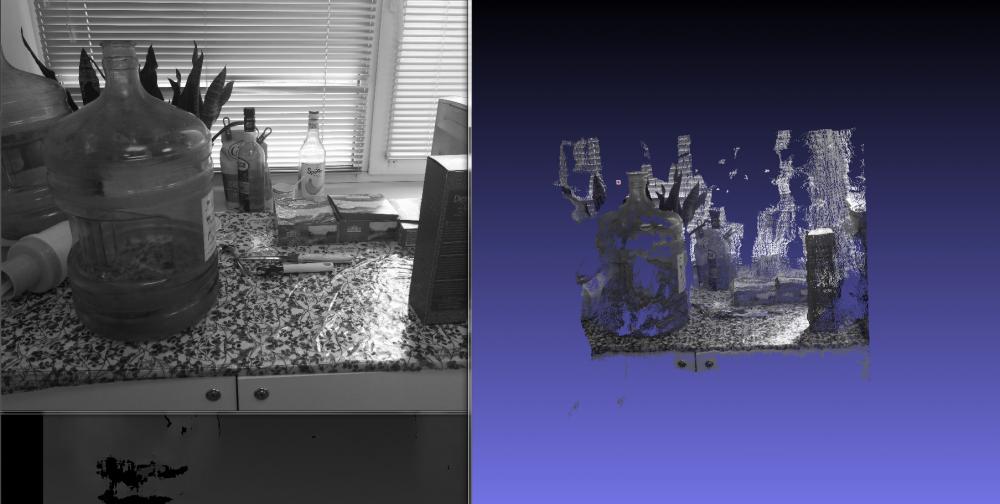

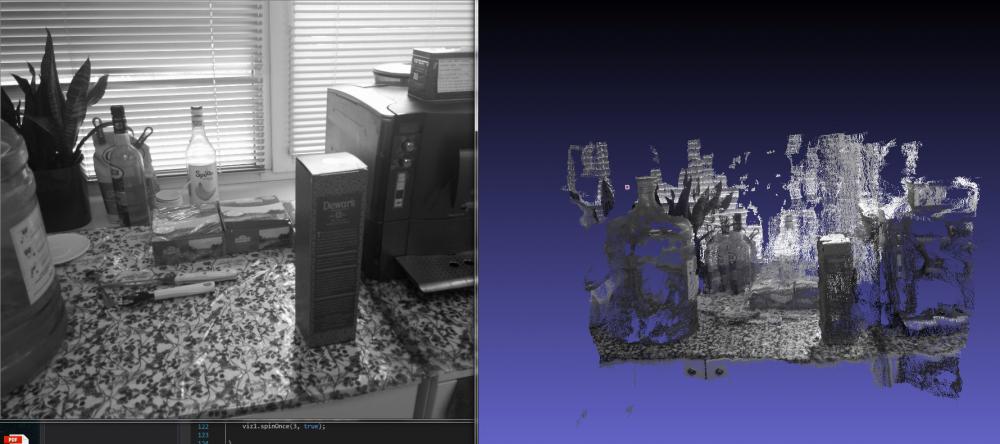

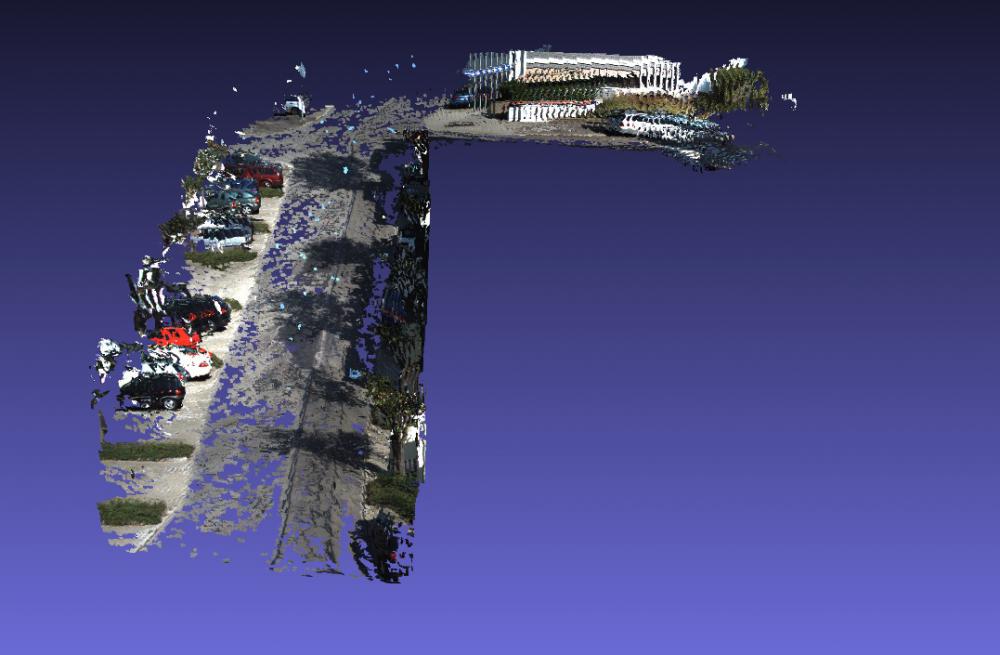

Продолжаю тему Structure from motion (3d reconstruction). Появились первые результаты работы (см. ниже), сделан конвейер, на входе стерео кадры, на выходе 3d сцена. На данный момент решаю две проблемы:

- Избавление от наложения моделей друг на друга в следствии вычислительных ошибок и т.д

- Избавление сцены от избыточности в следствии повторения одинаковых элементов

По первому пункту склоняюсь к ICP (Iterative Closest Point). По второму нет идей.

Хотелось бы узнать кто-нибудь использовал ICP с облаком точек на практике и есть ли примеры. Никак не разберусь в opencv вроде есть класс icp, но как с ним работать..

Фильтрация облака точек

в OpenCV

Опубликовано · Report reply

попробую на днях